Analizzare i dati relativi ai pazienti in un ospedale per migliorare la qualità delle cure, monitorare le abitudini di acquisto dei clienti per misurare l’efficacia delle offerte commerciali, verificare i dati delle reti elettriche per predire le frodi, oppure capire quali sono le sequenze di eventi che hanno portato alla rottura del cambio della vettura: sono solo alcuni esempi dei molteplici campi di utilizzo dei cosiddetti big data, che saranno oggetto del seminario organizzato dal Politecnico di Torino il 27 aprile prossimo “BigData@PoliTo”.

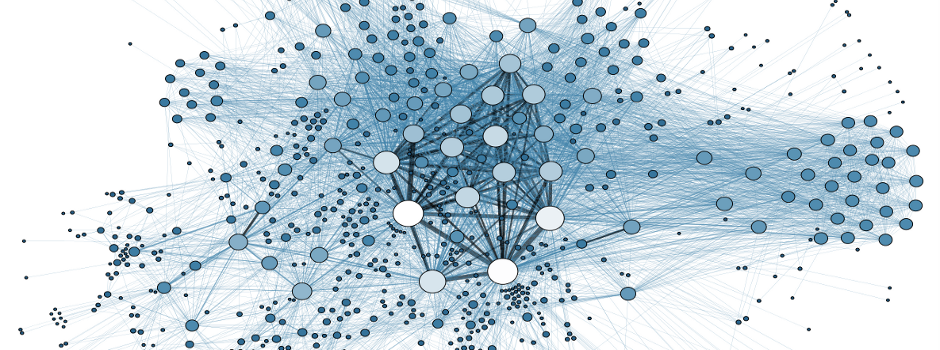

Il Politecnico di Torino si è dotato di un laboratorio interdipartimentale dedicato all’analisi dei Big Data, BigData@PoliTo, che vede il coinvolgimento dei Dipartimenti di Elettronica e Telecomunicazioni – DET, Automatica e Informatica – DAIUN, Ingegneria Gestionale e della Produzione – DIGEP e di Scienze Matematiche – DISMA. Il Laboratorio ha permesso la creazione di un centro di calcolo aperto, flessibile, basato su soluzioni open source e rivolto non solo ai ricercatori e docenti del Politecnico per i loro progetti, ma che si apre ora anche al mondo aziendale, sempre più interessato allo studio dei Big Data per finalità differenti, che vanno dal marketing, alla definizione di algoritmi innovativi, da applicazioni al mondo del Web, alla progettazione di sistemi completi e che verranno presentate nel corso del workshop. Il Politecnico si candida così a diventare un centro di riferimento italiano, ma anche europeo, su queste tematiche, considerato che oggi il centro internazionale di riferimento si trova negli Stati Uniti, all’Università di Berkeley.